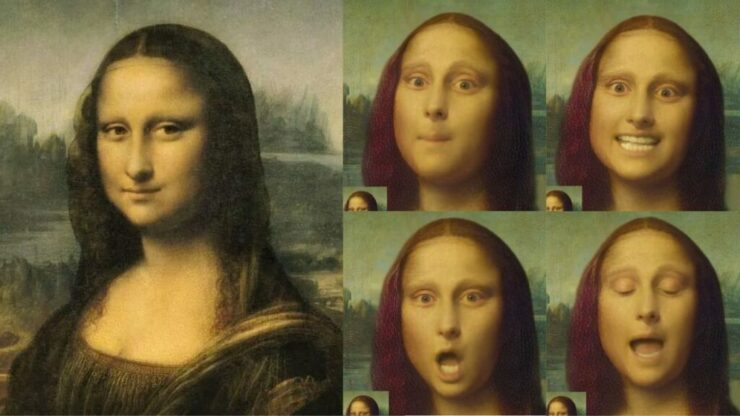

Il framework Vasa-1 di Microsoft rappresenta un passo avanti nel mondo dell’intelligenza artificiale, in grado di trasformare ritratti fotografici di teste umane in video che parlano e cantano in maniera molto realistica. Questo sistemasviluppato da Microsoft Research Asia, ha l’obiettivo di creare avatar realistici che possano interagire in tempo reale con comportamenti umani naturali. Vasa-1 è dunque capace di creare deepfake credibili utilizzando solo una foto e un file audio, sollevando interessanti questioni sul futuro della manipolazione digitale.

Microsoft just dropped VASA-1.

This AI can make single image sing and talk from audio reference expressively. Similar to EMO from Alibaba

10 wild examples:

1. Mona Lisa rapping Paparazzi pic.twitter.com/LSGF3mMVnD

— Min Choi (@minchoi) April 18, 2024

Utilizzando il machine learning, il modello sincronizza i movimenti del volto e del capo con il lip-sync per ottenere un effetto credibile e naturale. Questa tecnologia è in grado di generare video ad alta risoluzione con una buona frequenza di frame, rendendola adatta anche per videoconferenze e interazioni in tempo reale.

Nonostante le potenzialità impressionanti di Vasa-1, sorge il timore che l’avvento di sistemi così avanzati possa rendere sempre più difficile distinguere tra video reali e manipolati. Tecnologie simili, come Emo di Alibaba e Sora di OpenAI, stanno già dimostrando le incredibili capacità dell’intelligenza artificiale nell’ambito della generazione di contenuti audiovisivi. Anche se al momento il codice di Vasa-1 non è disponibile al pubblico, è fondamentale continuare a sviluppare sistemi che possano rilevare con precisione contenuti generati artificialmente, al fine di contrastare la diffusione di fake news e disinformazione. La necessità di una maggiore consapevolezza sull’origine e l’autenticità dei contenuti digitali diventa sempre più evidente in un’era in cui la manipolazione dei media è sempre più sofisticata e diffusa.

L’articolo Vasa-1: Microsoft crea deepfake canterini! proviene da CorriereNerd.it.

Aggiungi un commento